RNN简介

现实世界中,很多元素都是相互连接的,比如室外的温度是随着气候的变化而周期性的变化的、我们的语言也需要通过上下文的关系来确认所表达的含义。但是机器要做到这一步就相当得难了。因此,就有了现在的循环神经网络,他的本质是:拥有记忆的能力,并且会根据这些记忆的内容来进行推断。因此,他的输出就依赖于当前的输入和记忆。

网络结构及原理

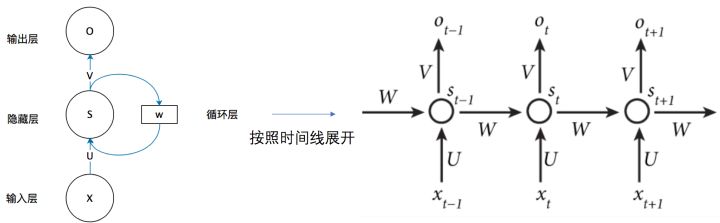

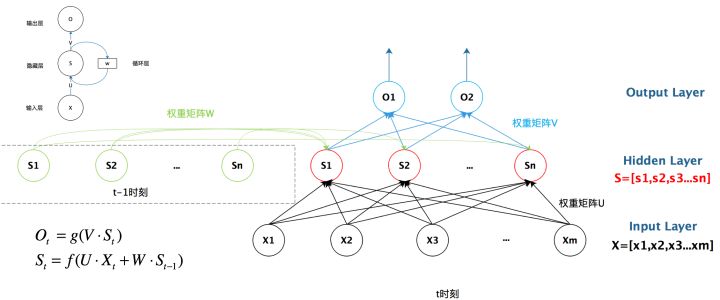

循环神经网络的基本结构特别简单,就是将网络的输出保存在一个记忆单元中,这个记忆单元和下一次的输入一起进入神经网络中。

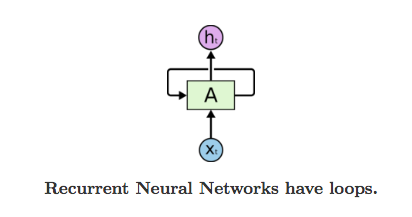

一个最简单的循环神经网络在输入时的结构示意图:

RNN 可以被看做是同一神经网络的多次赋值,每个神经网络模块会把消息传递给下一个,我们将这个图的结构展开:

根据循环神经网络的结构也可以看出它在处理序列类型的数据上具有天然的优势。因为网络本身就是 一个序列结构,这也是所有循环神经网络最本质的结构。

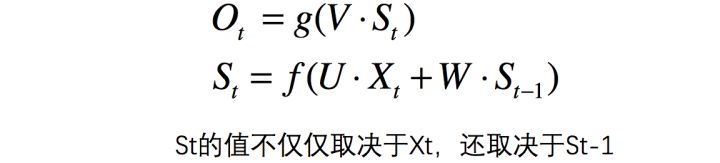

我们可以用下面的公式来表示循环神经网络的计算方法:

总结图:

Pytorch中

pytorch 中使用 nn.RNN 类来搭建基于序列的循环神经网络,它的构造函数有以下几个参数:

input_size:输入数据X的特征值的数目。hidden_size:隐藏层的神经元数量,也就是隐藏层的特征数量。num_layers:循环神经网络的层数,默认值是 1。bias:默认为 True,如果为 false 则表示神经元不使用 bias 偏移参数。batch_first:如果设置为 True,则输入数据的维度中第一个维度就是 batch 值,默认为 False。默认情况下第一个维度是序列的长度, 第二个维度才是batch,第三个维度是特征数目。dropout:如果不为空,则表示最后跟一个 dropout 层抛弃部分数据,抛弃数据的比例由该参数指定

RNN 中最主要的参数是 input_size 和 hidden_size,这两个参数务必要搞清楚。其余的参数通常不用设置,采用默认值就可以了。

rnn = torch.nn.RNN(20,50,2)

input = torch.randn(100 , 32 , 20)

h_0 =torch.randn(2 , 32 , 50)

output,hn=rnn(input ,h_0)

print(output.size(),hn.size())

'''

torch.Size([100, 32, 50]) torch.Size([2, 32, 50])

'''

LSTM

Long Short Term Memory Networks 长短期记忆网络

它解决了短期依赖的问题,并且它通过刻意的设计来避免长期依赖问题

思路

原始 RNN 的隐藏层只有一个状态,即h,它对于短期的输入非常敏感。

再增加一个状态,即c,让它来保存长期的状态,称为单元状态(cell state)。

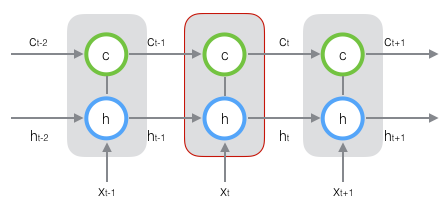

把上图按照时间维度展开:

在 t 时刻,LSTM 的输入有三个:

- 当前时刻网络的输入值 x_t

- 上一时刻 LSTM 的输出值 h_t-1

- 上一时刻的单元状态 c_t-1

LSTM 的输出有两个:

- 当前时刻 LSTM 输出值 h_t

- 当前时刻的单元状态 c_t

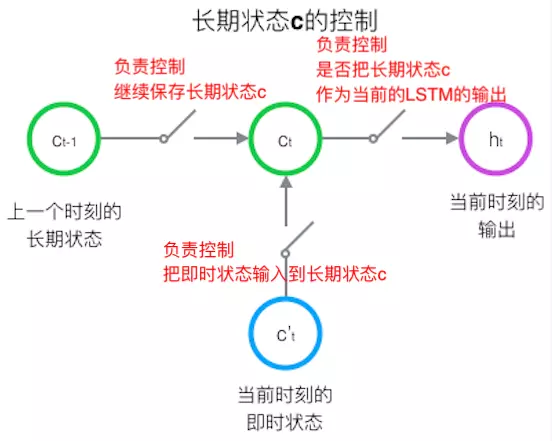

控制长期状态c

LSTM中使用三个控制开关来控制

结构

标准的循环神经网络内部只有一个简单的层结构,而 LSTM 内部有 4 个层结构:

-

忘记层:决定状态中丢弃什么信息

-

tanh层:用来产生更新值的候选项,说明状态在某些维度上需要加强,在某些维度上需要减弱

-

sigmoid层(输入门层): 它的输出值要乘到tanh层的输出上,起到一个缩放的作用,极端情况下sigmoid输出0说明相应维度上的状态不需要更新

-

最后一层决定输出什么,输出值跟状态有关。候选项中的哪些部分最终会被输出由一个sigmoid层来决定。

Pytorch中

pytorch 中使用 nn.LSTM 类来搭建基于序列的循环神经网络,他的参数基本与RNN类似

lstm = torch.nn.LSTM(10, 20,2)

input = torch.randn(5, 3, 10)

h0 =torch.randn(2, 3, 20)

c0 = torch.randn(2, 3, 20)

output, hn = lstm(input, (h0, c0))

print(output.size(),hn[0].size(),hn[1].size())

'''

torch.Size([5, 3, 20]) torch.Size([2, 3, 20]) torch.Size([2, 3, 20])

'''

GRU

Gated Recurrent Units

GRU 和 LSTM 最大的不同在于 GRU 将遗忘门和输入门合成了一个"更新门",同时网络不再额外给出记忆状态,而是将输出结果作为记忆状态不断向后循环传递,网络的输人和输出都变得特别简单。

Pytorch中

rnn = torch.nn.GRU(10, 20, 2)

input = torch.randn(5, 3, 10)

h_0= torch.randn(2, 3, 20)

output, hn = rnn(input, h0)

print(output.size(),h0.size())

'''

torch.Size([5, 3, 20]) torch.Size([2, 3, 20])

'''

循环网络的向后传播 BPTT

在向前传播的情况下,RNN的输入随着每一个时间步前进。在反向传播的情况下,我们“回到过去”改变权重,因此我们叫它通过时间的反向传播(BPTT)

我们通常把整个序列(单词)看作一个训练样本,所以总的误差是每个时间步(字符)中误差的和。权重在每一个时间步长是相同的(所以可以计算总误差后一起更新)。

- 使用预输出和实际输出计算交叉熵误差

- 网络按照时间步完全展开

- 对于展开的网络,对于每一个时间步计算权重的梯度

- 因为对于所有时间步来说,权重都一样,所以对于所有的时间步,可以一起得到梯度(而不是像神经网络一样对不同的隐藏层得到不同的梯度)

- 随后对循环神经元的权重进行升级

RNN展开的网络看起来像一个普通的神经网络。反向传播也类似于普通的神经网络,只不过我们一次得到所有时间步的梯度。如果有100个时间步,那么网络展开后将变得非常巨大,所以为了解决这个问题才会出现LSTM和GRU这样的结构。

RNN用于NLP时的储备知识

词嵌入 word embedding

为了让计算机能够能更好地理解我们的语言,建立更好的语言模型,我们需要将词汇进行表征。

在图像分类问题会使用 one-hot 编码。比如LeNet中一共有10个数字0-9,如果这个数字是2的话,它的编码就是 (0,0,1,0, 0,0 ,0,0,0,0),对于分类问题这样表示十分的清楚。

但是在自然语言处理中,因为单词的数目过多比如有 10000 个不同的词,那么使用 one-hot 这样的方式来定义,效率就特别低,并且占用内存,也不能体现单词的词性, one-hot 没办法体现这个特点,所以 必须使用另外一种方式定义每一个单词。

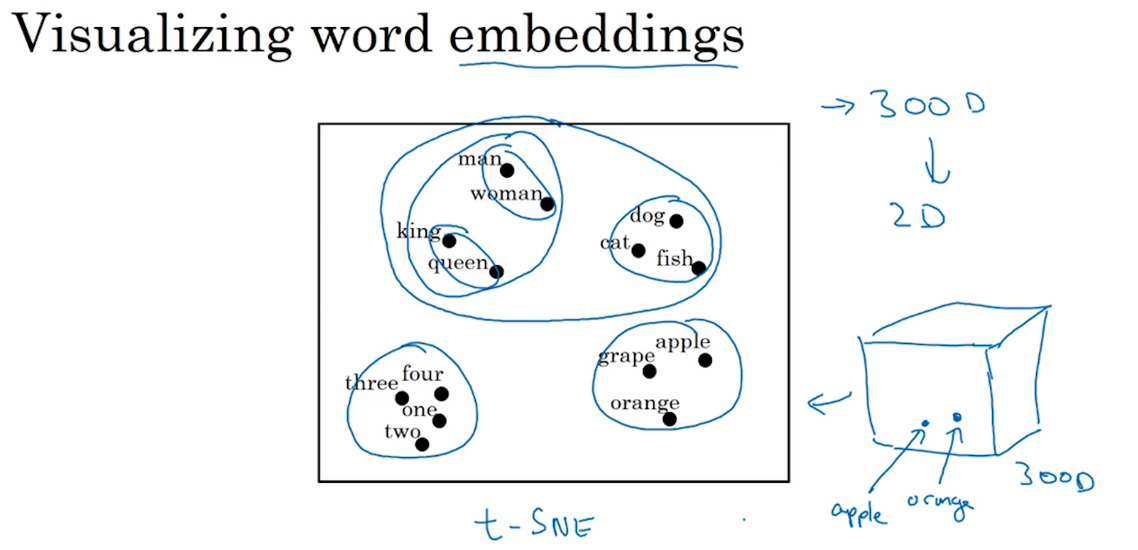

用不同的特征来对各个词汇进行表征,相对于不同的特征,不同的单词均有不同的值,这就是词嵌入

词嵌入不仅对不同单词实现了特征化的表示,还能通过计算词与词之间的相似度

实际上是在多维空间中,寻找词向量之间各个维度的距离相似度,我们就可以实现类比推理,比如说夏天和热,冬天和冷,都是有关联关系的。

在 PyTorch 中我们用 nn.Embedding 层来做嵌入词袋模型,Embedding层第一个输入表示我们有多少个词,第二个输入表示每一个词使用多少维度的向量表示。

# an Embedding module containing 10 tensors of size 3

embedding = torch.nn.Embedding(10, 3)

# a batch of 2 samples of 4 indices each

input = torch.LongTensor([[1,2,4,5],[4,3,2,9]])

output=embedding(input)

print(output.size())

'''

torch.Size([2, 4, 3])

'''

Beam Search

在生成第一个词的分布后,可以使用贪心搜索会根据我们的条件语言模型挑选出最有可能输出的第一个词语,但是对于贪心搜索算法来说,我们的单词库中有成百到千万的词汇,去计算每一种单词的组合的可能性是不可行的。所以我们使用近似的搜索办法,使得条件概率最大化或者近似最大化的句子,而不是通过单词去实现。

Beam Search(集束搜索)是一种启发式图搜索算法,通常用在图的解空间比较大的情况下,为了减少搜索所占用的空间和时间,在每一步深度扩展的时候,剪掉一些质量比较差的结点,保留下一些质量较高的结点。虽然Beam Search算法是不完全的,但是用于了解空间较大的系统中,可以减少空间占用和时间。

Beam search可以看做是做了约束优化的广度优先搜索,首先使用广度优先策略建立搜索树,树的每层,按照启发代价对节点进行排序,然后仅留下预先确定的个数(Beam width-集束宽度)的节点,仅这些节点在下一层次继续扩展,其他节点被剪切掉。

- 将初始节点插入到list中

- 将给节点出堆,如果该节点是目标节点,则算法结束;

- 否则扩展该节点,取集束宽度的节点入堆。然后到第二步继续循环。

- 算法结束的条件是找到最优解或者堆为空。

在使用上,集束宽度可以是预先约定的,也可以是变化的,具体可以根据实际场景调整设定。

注意力模型

对于使用编码和解码的RNN模型,我们能够实现较为准确度机器翻译结果。对于短句子来说,其性能是十分良好的,但是如果是很长的句子,翻译的结果就会变差。 我们人类进行人工翻译的时候,都是一部分一部分地进行翻译,引入的注意力机制,和人类的翻译过程非常相似,其也是一部分一部分地进行长句子的翻译。